- Von Redaktion

- 24.03.2023 um 10:46

Spätestens seit ChatGPT wird über Künstliche Intelligenz (KI) wieder auf zahlreichen Plattformen und Kanälen gesprochen. Mithilfe von Machine Learning (ML) können Muster in Daten ohne explizite Programmierung von der KI erkannt, verknüpft und verarbeitet werden. Auch in der Versicherungsbranche werden die vielseitigen Einsatzmöglichkeiten von KI/ML-Modellen zunehmend erkannt.

Die ZEB Use Case Landkarte für Versicherungen zeigt dabei mögliche Anwendungsfälle entlang der gesamten Wertschöpfungskette auf: Beispielsweise können durch KI-gestützte Prognosemodelle Schadens- und Leistungsfälle vorhergesagt, Betrugsversuche erkannt und Stornoquoten gesenkt werden. Laut Erhebungen seitens Zeb werden Potenziale bezüglich KI/ML bisher nur im geringen Maße genutzt, allerdings haben bereits 44 Prozent der befragten Häuser erste KI/ML-Modelle eingeführt oder Piloten verprobt, jedes vierte Unternehmen plant zudem Projekte in diesem Bereich.

Zunehmende regulatorische Aktivitäten

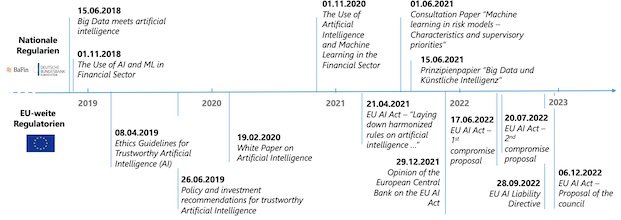

Das Potential von KI wird auch von den Aufsichtsbehörden erkannt. Neben bereits bestehenden IT-bezogenen Vorgaben, wie versicherungsaufsichtsrechtliche Anforderungen an die IT (VAIT) oder die Datenschutzgrundverordnung (DSGVO), hat die regulatorische Aufmerksamkeit auch für das Thema KI in den letzten Jahren auf nationaler wie supranationaler Ebene einen stetigen Zuwachs erfahren (siehe erste Grafik). Sowohl die Bafin als auch die EU-Kommission lassen in ihren Veröffentlichungen verschiedenste regulatorische Anforderungen anklingen, die den gesamten Entwicklungsprozess von KI/ML-Anwendungen beeinflussen können.

Sobald sich Versicherer dazu entschließen, KI/ML-Systeme aktiv zu nutzen, sollten sie sich deshalb auch mit den gesetzlichen Rahmenbedingungen und aktuellen aufsichtsrechtlichen Aktivitäten auseinandersetzen. Werden regulatorische Vorgaben nicht bereits bei Beginn der Implementierung eines Use Cases berücksichtigt, kann dies später zu erheblich höheren Kosten und Umsetzungszeiten oder gar zu einem Einsatzstopp der bereits entwickelten Anwendung führen.

Zum Vergrößern der Grafik hier klicken.

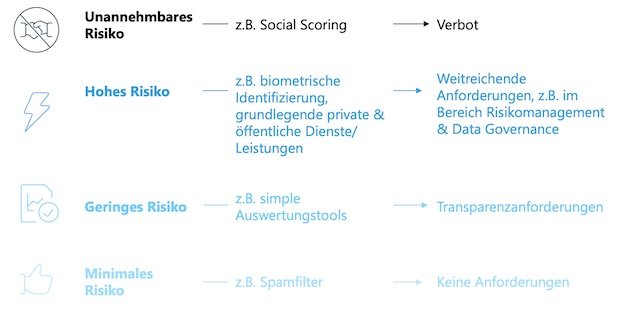

Während die Bafin Konsultations- und Prinzipienpapieren zu ML und KI veröffentlicht, ebnet die EU-Kommission bereits den Weg für verbindliche EU-weite Regelungen. Das Inkrafttreten der im April 2021 im Entwurf vorgestellten KI-Verordnung („AI Act“) wird von ZEB bereits Ende 2023 erwartet. Der AI Act verfolgt einen risikobasierten Ansatz, der unterschiedlich starke Regulierungsansätze für vier unterschiedliche Risikoklassen (minimales bis unannehmbares Risiko) vorsieht (siehe Grafik unten).

Für KI/ML-Anwendungen mit geringem Risiko, wie beispielsweise einfach gehaltene Tools für die Berechnung von Abwanderungsquoten, sieht der AI Act lediglich Transparenzpflichten vor, wohingegen weitaus strengere Anforderungen an Hochrisiko-Anwendungen* gestellt werden. Für diese wird zum Beispiel die Etablierung eines Risikomanagementsystems, Anforderungen an menschliche Aufsicht über die Systeme und Transparenz über Robustheit und Sicherheit der Anwendung gefordert.

Für Versicherer könnten zukünftig zentrale KI/ML-Systeme als Hochrisiko-Anwendungen eingestuft werden, beispielsweise solche zur automatisierten Schadensregulierung und Betrugserkennung. Zudem könnten auch biometrische Anwendungen betroffen sein, zum Beispiel für die biometrische Identifikation von Mitarbeitern, Bewerbern und Kunden.

*Hierunter sind Anwendungen zu verstehen, die laut Verordnungsentwurf „erhebliche Risiken für die Gesundheit und Sicherheit oder die Grundrechte von Personen bergen“.

0 Kommentare

- anmelden

- registrieren

kommentieren